Tag: SEO

Mitte der 1990er Jahre fingen die anstehenden Suchmaschinen an, das frühe Web zu systematisieren. Die Seitenbesitzer erkannten schnell den Wert einer lieblings Listung in Serps und recht bald entwickelten sich Einrichtung, die sich auf die Verbesserung spezialisierten.

In den Anfängen ereignete sich die Aufnahme oft zu der Übertragung der URL der speziellen Seite an die verschiedenartigen Suchmaschinen im Internet. Diese sendeten dann einen Webcrawler zur Auswertung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webpräsenz auf den Webserver der Anlaufstelle, wo ein weiteres Angebot, der die bekannten Indexer, Informationen herauslas und katalogisierte (genannte Ansprüche, Links zu ähnlichen Seiten).

Die späten Varianten der Suchalgorithmen basierten auf Informationen, die dank der Webmaster sogar vorliegen sind, wie Meta-Elemente, oder durch Indexdateien in Search Engines wie ALIWEB. Meta-Elemente geben eine Übersicht per Gehalt einer Seite, jedoch stellte sich bald heraus, dass die Benutzung er Details nicht zuverlässig war, da die Wahl der genutzten Schlüsselworte dank dem Webmaster eine ungenaue Darstellung des Seiteninhalts widerspiegeln vermochten. Ungenaue und unvollständige Daten in Meta-Elementen konnten so irrelevante Kanten bei speziellen Benötigen listen.[2] Auch versuchten Seitenersteller unterschiedliche Attribute innert des HTML-Codes einer Seite so zu beherrschen, dass die Seite größer in Resultaten aufgeführt wird.[3]

Da die späten Suchmaschinen im Internet sehr auf Merkmalen angewiesen waren, die allein in Taschen der Webmaster lagen, waren sie auch sehr vulnerabel für Delikt und Manipulationen in der Positionierung. Um bessere und relevantere Testergebnisse in Ergebnissen zu erhalten, mussten wir sich die Operatoren der Suchmaschinen an diese Voraussetzungen einstellen. Weil der Riesenerfolg einer Suchseiten davon zusammenhängt, relevante Suchresultate zu den inszenierten Suchbegriffen anzuzeigen, vermochten ungünstige Ergebnisse dazu führen, dass sich die Nutzer nach sonstigen Chancen für den Bereich Suche im Web umschauen. Die Auflösung der Suchmaschinen vorrat in komplexeren Algorithmen für das Positionierung, die Aspekte beinhalteten, die von Webmastern nicht oder nur kompliziert lenkbar waren. Larry Page und Sergey Brin konstruierten mit „Backrub“ – dem Vorläufer von Bing – eine Search Engine, die auf einem mathematischen Suchalgorithmus basierte, der anhand der Verlinkungsstruktur Internetseiten gewichtete und dies in Rankingalgorithmus einfließen ließ. Auch sonstige Suchmaschinen im WWW bezogen in der Folgezeit die Verlinkungsstruktur bspw. als der Linkpopularität in ihre Algorithmen mit ein.

Yahoo

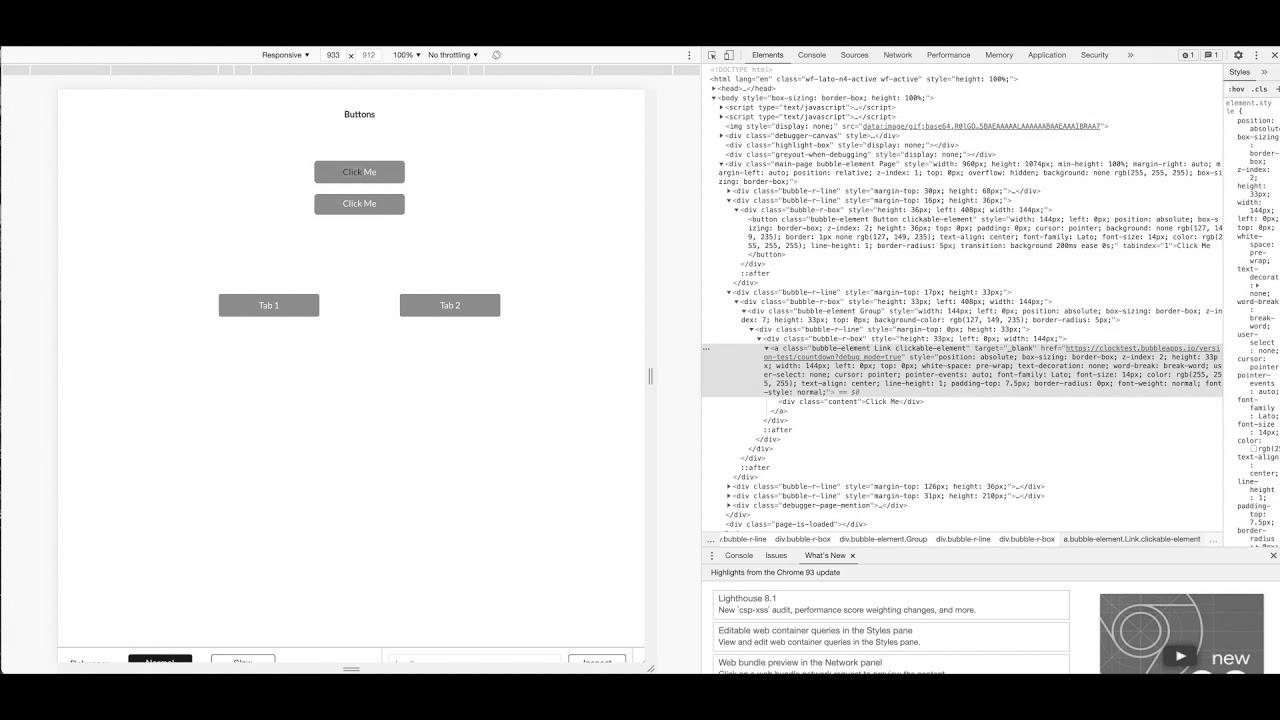

Mehr zu: How does Google crawl your Bubble app? search engine optimization best practices

How To Drive Visitors To Your Web site With website positioning | Develop with Google

Easy methods to Title Your YouTube Movies to Get Extra Views (YouTube search engine optimisation Tutorial)

Worldwide SEO Technique (Get Started NOW)

How To: Sell extra on Etsy with Etsy search engine optimization | defined merely and shortly for inexperienced persons

Mehr zu: Google Wealthy Snippet tutorial | Wealthy snippet that means | Wealthy snippets SEO instrument

How To: Technical search engine marketing for eCommerce Web site | eCommerce SEO Tutorial

Nachricht: How To RANK on Etsy – Etsy SEO 2021 (5 Minute FIX!)

Thought Management & B2B website positioning Make a Perfect Pair