Tag: SEO

Mitte der 1990er Jahre fingen die allerersten Suchmaschinen an, das frühe Web zu systematisieren. Die Seitenbesitzer erkannten schnell den Wert einer bevorzugten Positionierung in Serps und recht bald entstanden Einrichtung, die sich auf die Verbesserung ausgerichteten.

In Anfängen erfolgte die Aufnahme oft über die Übertragung der URL der richtigen Seite in puncto vielfältigen Search Engines. Diese sendeten dann einen Webcrawler zur Untersuchung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Homepage auf den Server der Search Engine, wo ein 2. Programm, der gern genutzte Indexer, Angaben herauslas und katalogisierte (genannte Ansprüche, Links zu anderen Seiten).

Die damaligen Varianten der Suchalgorithmen basierten auf Angaben, die durch die Webmaster eigenständig vorgegeben werden, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im Netz wie ALIWEB. Meta-Elemente geben eine Gesamtübersicht mit Essenz einer Seite, gewiss stellte sich bald heraus, dass die Verwendung dieser Details nicht zuverlässig war, da die Wahl der eingesetzten Schlüsselworte dank dem Webmaster eine ungenaue Präsentation des Seiteninhalts spiegeln kann. Ungenaue und unvollständige Daten in den Meta-Elementen vermochten so irrelevante Websites bei speziellen Ausschau halten listen.[2] Auch versuchten Seitenersteller mehrere Punkte im Laufe des HTML-Codes einer Seite so zu manipulieren, dass die Seite stärker in den Serps gelistet wird.[3]

Da die damaligen Internet Suchmaschinen sehr auf Punkte dependent waren, die bloß in den Händen der Webmaster lagen, waren sie auch sehr labil für Falscher Gebrauch und Manipulationen in der Positionierung. Um bessere und relevantere Testergebnisse in den Resultaten zu bekommen, mussten sich die Unternhemer der Suchmaschinen im Netz an diese Faktoren angleichen. Weil der Erfolg einer Suchseiten davon abhängt, wesentliche Ergebnisse der Suchmaschine zu den inszenierten Suchbegriffen anzuzeigen, konnten unangebrachte Resultate zur Folge haben, dass sich die Mensch nach anderen Wege bei der Suche im Web umsehen. Die Rückmeldung der Suchmaschinen im WWW fortbestand in komplexeren Algorithmen beim Rangordnung, die Gesichtspunkte beinhalteten, die von Webmastern nicht oder nur schwierig lenkbar waren. Larry Page und Sergey Brin gestalteten mit „Backrub“ – dem Vorläufer von Die Suchmaschine – eine Suchmaschine, die auf einem mathematischen Algorithmus basierte, der mit Hilfe der Verlinkungsstruktur Kanten gewichtete und dies in den Rankingalgorithmus einfließen ließ. Auch andere Suchmaschinen überzogen in Mitten der Folgezeit die Verlinkungsstruktur bspw. wohlauf der Linkpopularität in ihre Algorithmen mit ein.

Suchmaschinen

Nachricht: "Make Your Wish Come True" || Blibli Rooftalks – Park Seo Jun 💙

How To Add Internal links in WordPress like a Ninja – SEO Technique

Mehr zu: How you can Create and Install Structured Information for Local web optimization

The right way to create a Google Analytics search engine marketing dashboard

Mitteilung: YouTube search engine optimization Complete Guide Tutorial For Inexperienced persons || Hindi

Mitteilung: Create XML Sitemaps for WordPress using the WordPress web optimization by Yoast Plugin | WP Studying Lab

YouTube website positioning | Make Viral Videos | Get More Views & Subscribers | Finest App for Youtubers – 2017

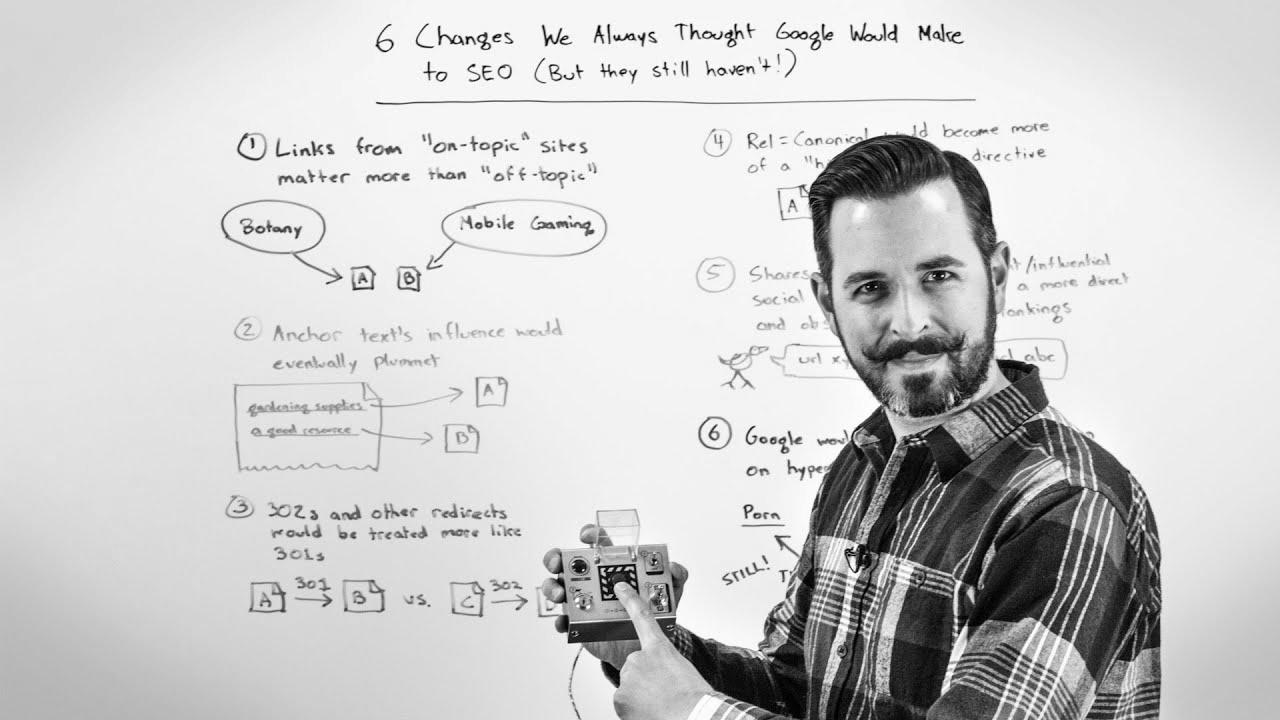

6 Modifications We Thought Google Would Make to SEO But They Still Have not – Whiteboard Friday

🤑Earn $30Day From Adsense – Rank #1 On Google Without website positioning 🔥 Make Cash On-line Hindi BloggingQnA